على الرغم من توفر شبكة Wi-Fi في كل مكان هذه الأيام ، إلا أنك قد تجد نفسك بدون أي اتصال بالإنترنت من وقت لآخر. ومن أجل تجنب البقاء بدون مصادر مُخصصة ، قد تكون هناك مواقع ويب ترغب في حفظها حتى تتمكن من الوصول إليها أثناء عدم الاتصال بالإنترنت — ربما للبحث والترفيه.

من الأساسي جدًا حفظ صفحات الويب الفردية لقراءتها في وضع عدم الاتصال ، ولكن ماذا لو كنت تُريد تنزيل موقع ويب بأكمله؟ لا تقلق ، الأمر أسهل مما تعتقد. إليك العديد من الأدوات الرائعة التي يُمكنك استخدامها لتنزيل أي موقع ويب لقراءة مُحتوياته دون اتصال بالإنترنت دون أي متاعب. تحقق من أفضل الأدوات لتنزيل بث الفيديو من أي موقع ويب.

روابط سريعة

1. WebCopy

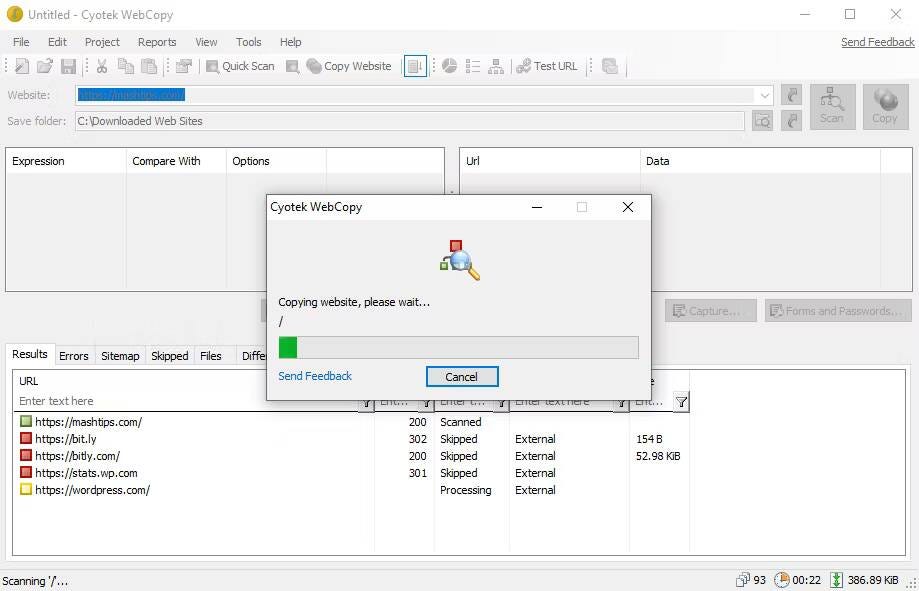

يأخذ WebCopy من Cyotek عنوان URL لموقع ويب ويفحصه بحثًا عن الروابط والصفحات والوسائط. عندما يعثر على الصفحات ، فإنه يبحث بشكل مُتكرر عن المزيد من الروابط والصفحات والوسائط حتى يتم اكتشاف موقع الويب بالكامل. ثم يُمكنك استخدام خيارات التكوين لتحديد الأجزاء المراد تنزيلها في وضع عدم الاتصال.

الشيء المُثير للاهتمام في WebCopy هو أنه يُمكنك إعداد عدة مشاريع لكل منها إعداداته وتكويناته الخاصة. هذا يجعل من السهل إعادة تنزيل العديد من مواقع الويب وقتما تشاء ؛ كل واحد ، بنفس الطريقة في كل مرة.

يُمكن لمشروع واحد نسخ العديد من مواقع الويب ، لذا استخدمه مع خطة مُنظمة (على سبيل المثال ، مشروع “Tech” لنسخ المواقع التقنية).

كيفية تنزيل موقع ويب كامل باستخدام WebCopy

من السهل جدًا حفظ موقع ويب بأكمله باستخدام هذا التطبيق. إليك الطريقة:

- قم بتثبيت التطبيق وتشغيله.

- انتقل إلى

ملف -> جديدلإنشاء مشروع جديد. - اكتب عنوان URL في حقل موقع الويب.

- قم بتغيير حقل حفظ المجلد إلى المكان الذي تُريد حفظ موقع الويب فيه.

- يُمكنك التعديل على المشروع -> القواعد … (تعرف على المزيد حول قواعد WebCopy).

- انتقل إلى ملف -> حفظ باسم … لحفظ المشروع.

- انقر فوق “نسخ” في شريط الأدوات لبدء العملية.

بمجرد الانتهاء من النسخ ، يُمكنك استخدام علامة التبويب النتائج لمعرفة حالة كل صفحة فردية و / أو ملف وسائط. تعرض علامة التبويب “الأخطاء” أي مشاكل قد تكون حدثت ، وتعرض علامة التبويب “تم تخطي” الملفات التي لم يتم تنزيلها. ولكن الأهم هو ملف Sitemap ، الذي يعرض بنية الدليل الكاملة لموقع الويب كما اكتشفها WebCopy.

لعرض موقع الويب في وضع عدم الاتصال ، افتح مستكشف الملفات وانتقل إلى المجلد المحفوظ الذي قمت بتعيينه مسبقًا. افتح index.html (أو في بعض الأحيان index.htm) في المتصفح الذي تختاره لبدء التصفح. كما ترى ، يختلف هذا كثيرًا عن حفظ صفحات الويب الفردية من خلال التطبيقات ، وهي مُمارسة أخرى شائعة جدًا في الوقت الحاضر.

تنزيل: WebCopy لـ Windows (مجانًا)

2. HTTrack

HTTrack معروف أكثر من WebCopy ، ويُمكن القول أنه أفضل لأنه مفتوح المصدر ومُتوفر على أنظمة أساسية أخرى غير Windows. الواجهة مُكتظة بعض الشيء وتترك الكثير مما هو مرغوب. ومع ذلك ، فهو يعمل بشكل جيد ، لذلك لا تدع ذلك يُبعدك عن استخدامه.

مثل WebCopy ، يستخدم أسلوبًا قائمًا على المشروع يُتيح لك نسخ مواقع ويب مُتعددة والحفاظ عليها كلها منظمة. يُمكنك إيقاف التنزيلات مؤقتًا واستئنافها ، ويُمكنك تحديث مواقع الويب المنسوخة عن طريق إعادة تنزيل الملفات القديمة والجديدة.

كيفية تنزيل موقع الويب الكامل باستخدام HTTrack

للحصول على موقع الويب المُفضل بالكامل لاستخدامه دون اتصال ، اتبع الخطوات أدناه:

- قم بتثبيت التطبيق وتشغيله.

- انقر فوق “التالي” لبدء إنشاء مشروع جديد.

- امنح المشروع اسمًا وفئةً ومسارًا أساسيًا ، ثم انقر فوق التالي.

- حدد تنزيل موقع (مواقع) الويب لبدء الإجراء ، ثم اكتب عنوان URL لكل موقع ويب في مربع عناوين الويب ، عنوان URL واحد في كل سطر. يُمكنك أيضًا تخزين عناوين URL في ملف TXT واستيراده ، وهو أمر مناسب عندما تُريد إعادة تنزيل نفس مواقع الويب لاحقًا. انقر فوق التالي.

- اضبط المُعلمات إذا كنت تريد ، ثم انقر فوق “إنهاء”.

بمجرد تنزيل كل شيء ، يُمكنك تصفح موقع الويب بشكل طبيعي ، ببساطة عن طريق الانتقال إلى مكان تنزيل الملفات وفتح index.html أو index.htm في مُتصفح الويب.

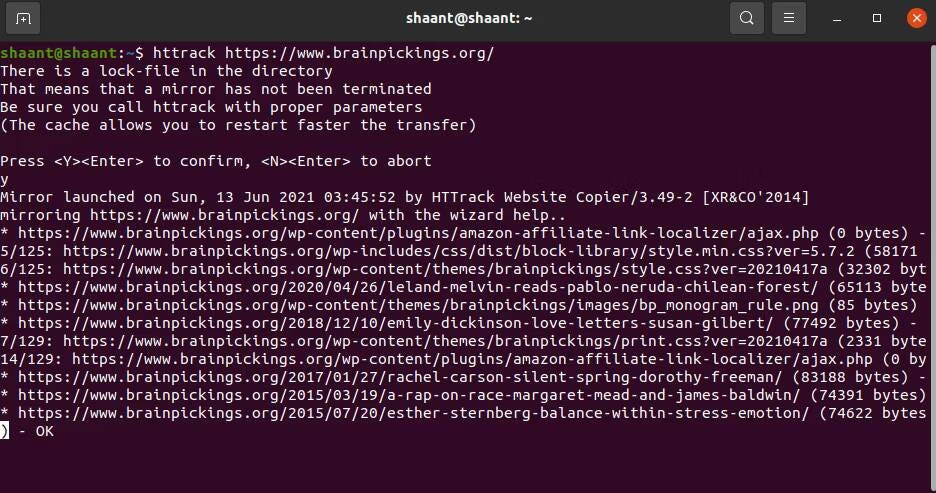

كيفية استخدام HTTrack على Linux

إذا كنت من مُستخدمي Ubuntu ، فإليك كيفية استخدام HTTrack لحفظ موقع ويب بأكمله:

- قم بتشغيل Terminal واكتب الأمر التالي:

sudo apt-get install httrack

- سيُطلب منك كلمة سر Ubuntu (إذا قمت بتعيين واحدة). اكتبها ، واضغط على Enter. سيقوم Terminal بتنزيل الأداة في غضون بضع دقائق.

- أخيرًا ، اكتب هذا الأمر واضغط على Enter. في هذا المثال ، قمنا بتنزيل موقع الويب الشهير ، Brain Pickings.

httrack https://www.brainpickings.org/

- سيؤدي هذا إلى تنزيل موقع الويب بالكامل لقراءته في وضع عدم الاتصال.

يُمكنك استبدال عنوان URL لموقع الويب هنا بعنوان URL الخاص بأي موقع ويب تُريد تنزيله. على سبيل المثال ، إذا أردت تنزيل Encyclopedia Britannica بالكامل ، فسيتعين عليك تعديل الأمر على النحو التالي:

httrack https://www.britannica.com/

تنزيل: HTTrack لـ Windows | Linux | Android (مجانًا)

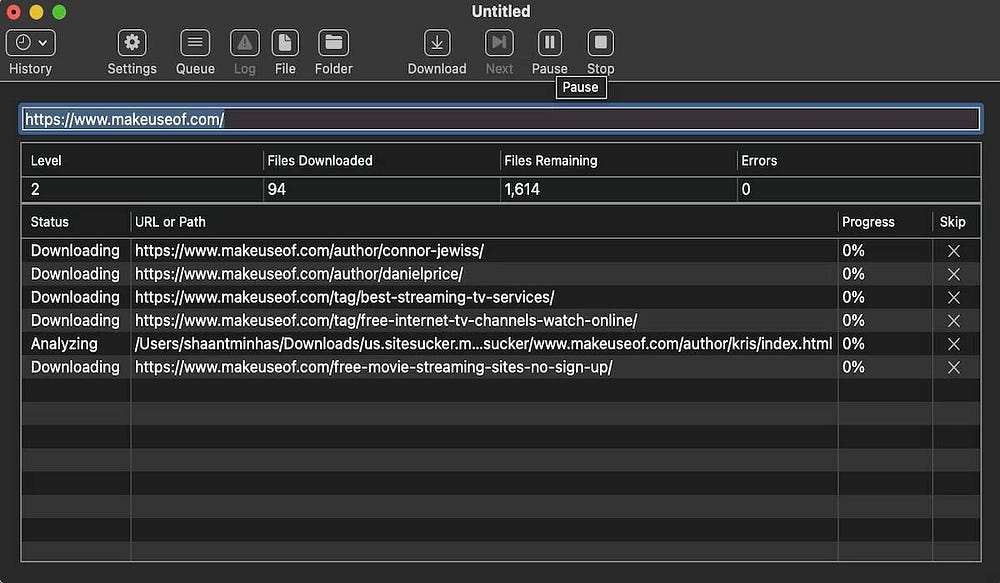

3. SiteSucker

إذا كنت تستخدم الـ Mac ، فإن أفضل خيار لك هو SiteSucker. يقوم هذا التطبيق البسيط بنسخ مواقع الويب بالكامل ، ويُحافظ على نفس البنية ، ويتضمن جميع ملفات الوسائط ذات الصلة أيضًا (على سبيل المثال ، الصور وملفات PDF وأوراق الأنماط). يحتوي على واجهة نظيفة وسهلة الاستخدام — تقوم حرفيًا فقط بلصق عنوان URL لموقع الويب والضغط على Enter.

تتمثل إحدى ميزاته الرائعة في القدرة على حفظ مدى تقدم التنزيل إلى ملف ، ثم استخدام هذا الملف لتنزيل نفس الملفات والهيكل مرة أخرى في المُستقبل (أو على جهاز آخر). هذه الميزة هي أيضًا ما يسمح لـ SiteSucker بإيقاف التنزيلات مؤقتًا واستئنافها.

تبلغ تكلفة SiteSucker حوالي 5 دولارات ولا يأتي مع إصدار مجاني أو نسخة تجريبية مجانية ، وهو أكبر جانب سلبي له. يتطلب أحدث إصدار منه macOS 11 Big Sur أو أي إصدار أعلى. تتوفر إصدارات أقدم من SiteSucker لأنظمة Mac القديمة ، ولكن قد تكون بعض الميزات مفقودة.

تنزيل: SiteSucker لنظام iOS | Mac (4.99 دولار)

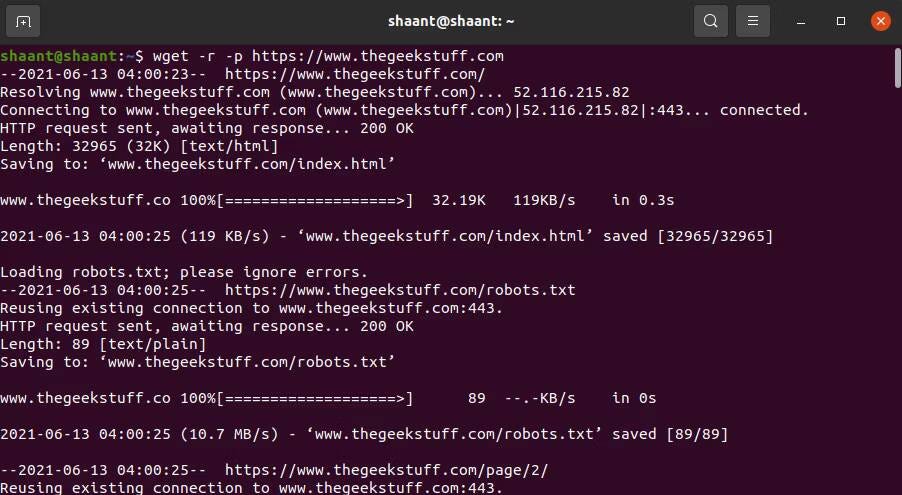

4. Wget

Wget هي أداة مُساعدة لسطر الأوامر يُمكنها استرداد جميع أنواع الملفات عبر بروتوكولات HTTP و FTP. نظرًا لأنَّ مواقع الويب يتم تقديمها من خلال بروتوكول HTTP ويُمكن الوصول إلى معظم ملفات وسائط الويب من خلال HTTP أو FTP ، فإنَّ هذا يجعل Wget أداة مُمتازة لتنزيل مواقع الويب بأكملها.

تأتي Wget مُرفقةً بمعظم الأنظمة التي تستند إلى Unix. بينما يتم استخدام Wget عادةً لتنزيل ملفات فردية ، يُمكن أيضًا استخدامها لتنزيل جميع الصفحات والملفات التي تم العثور عليها من خلال صفحة أولية بشكل مُتكرر:

wget -r -p https://www.domain.com

اعتمادًا على الحجم ، قد يستغرق تنزيل موقع الويب الكامل بعض الوقت.

ومع ذلك ، قد تكتشف بعض مواقع الويب ما تحاول القيام به وتمنعه لأن نسخ موقع ويب قد يُكلفها الكثير من النطاق الترددي. للتغلب على هذا ، يُمكنك التنكر كمتصفح ويب بسلسلة وكيل مُستخدم:

wget -r -p -U Mozilla https://www.domain.com

إذا كنت تُريد أن تكون مهذبًا ، فيجب عليك أيضًا تحديد سرعة التنزيل ، حتى لا تستهلك النطاق الترددي لخادم الويب. بالإضافة إلى ذلك ، يمكنك التوقف مؤقتًا بين كل تنزيل ، حتى لا تُربك خادم الويب بطلبات كثيرة. استخدم هذا الأمر:

wget -r -p -U Mozilla — wait=10 — limit-rate=35K https://www.domain.com

كيفية استخدام Wget على الـ Mac

على الـ Mac ، يُمكنك تثبيت Wget باستخدام أمر Homebrew واحد:

brew install wget

- إذا لم يكن لديك Homebrew مُثبتًا بالفعل ، فقم بتنزيله باستخدام هذا الأمر:

/usr/bin/ruby -e “$(curl -fsSL https://raw.githubusercontent.com/Homebrew/install/master/install)"

- بعد ذلك ، قم بتثبيت Wget باستخدام هذا الأمر:

brew install wget

- بعد الانتهاء من تثبيت Wget ، يُمكنك تنزيل موقع الويب باستخدام هذا الأمر:

wget path/to/local.copy http://www.domain.org/

في Windows ، ستحتاج إلى استخدام هذا الإصدار المنقول بدلاً منه. قم بتنزيل التطبيق وتثبيته ، واتبع التعليمات لإكمال تنزيل موقع الويب. تحقق من كيفية تثبيت واستخدام أداة wget على نظام macOS.

5. Teleport Pro

على الرغم من إطلاق الإصدار الأخير من التطبيق في عام 2015 ، إلا أنَّ التطبيق يعمل بنفس الجودة التي كان يعمل بها في ذلك الوقت.

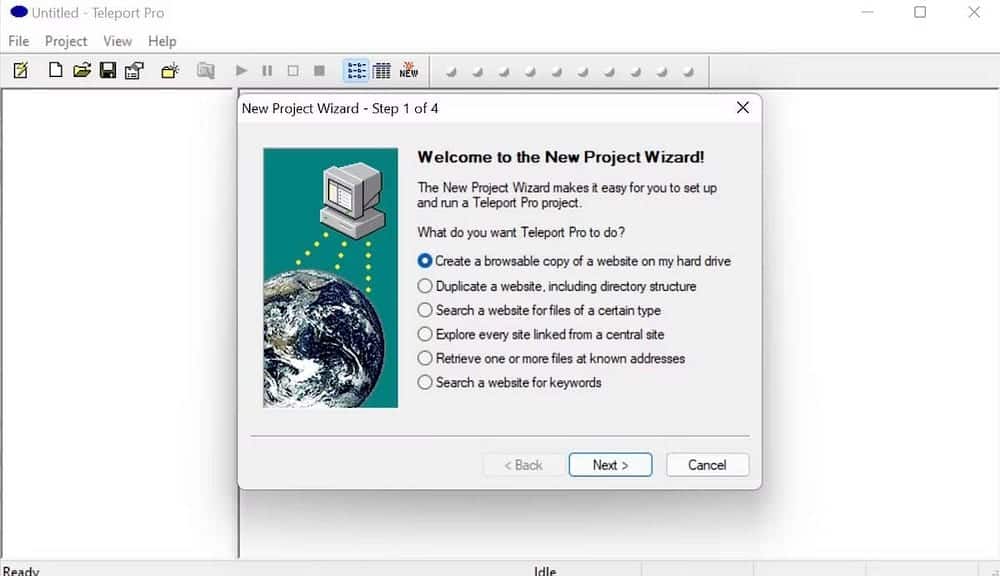

بصرف النظر عن مجرد تنزيل موقع ويب كامل ، فإنَّ التطبيق يحزم مجموعة من الميزات والتعقيدات الأخرى أيضًا. على سبيل المثال ، عند تنزيل التطبيق وتثبيته ، سترى في القائمة الرئيسية للتطبيق هذه الخيارات للاختيار من بينها:

- إنشاء نسخة من موقع الويب على القرص الصلب.

- تكرار موقع ويب بأكمله مع هيكل الدليل الخاص به.

- البحث في موقع الويب عن أنواع معينة من الملفات.

- البحث في موقع على شبكة الإنترنت عن كلمات رئيسية مُعينة.

- تصفح جميع مواقع الويب المرتبطة من موقع ويب مركزي.

هذه والعديد من الميزات المُماثلة الأخرى تجعل هذا التطبيق خيارًا مُفيدًا لمجموعة الأدوات التي تمتلكها. كان الجانب السلبي الوحيد الذي وجدناه هو القيود المفروضة في الإصدار المجاني. باستخدام الإصدار غير المُسجل ، يُمكنك فقط نسخ 500 صفحة في مشروع واحد. علاوة على ذلك ، لا يمكنك استخدامه إلا لما مجموعه 40 مرة ، وبعد ذلك سيتعين عليك شراء الإصدار المُتميز. تحقق من طرق لتنزيل مواقع الويب بالكامل للوصول إليها في وضع عدم الاتصال.

تنزيل: Teleport Pro لـ Windows (إصدار تجريبي مجاني ، إصدار مدفوع مُتاح)

6. Archivarix

تُعد Archivarix أداة أخرى لتنزيل موقع الويب وهي مُثيرة للاهتمام والتي ستُساعدك على تنزيل مواقع الويب الخاصة بك للاستخدام في وضع عدم الاتصال لاحقًا. بصرف النظر عن كونها أداة تنزيل بسيطة لموقع الويب ، فإنها تُساعدك أيضًا على استعادة ملفاتك من أرشيف الويب. ربما يكون الجانب السلبي الوحيد هو الحد الأقصى للإصدار المجاني الذي يُتيح لك فقط تنزيل 200 ملف دفعة واحدة.

كما أنها تُوفر إضافات WordPress سهلة الاستخدام والتي تتيح لك استيراد الصور من مواقع الويب التابعة لجهات خارجية.

ميزة أخرى لفتت انتباهنا كانت القدرة على تنزيل مواقع Onion الإلكترونية. لذا انطلق وجرب الإصدار المجاني. إذا كنت ترغب في ذلك ، فيُمكنك الانتقال إلى الإصدار المتميز التالي ، والذي سيكلفك حوالي 10 دولارات لكل ألف ملف. من هناك ، سيكون كل ألف تالٍ مقابل دولار واحد. ليست صفقة سيئة ، بالتأكيد! تحقق من أدوات Windows المجانية التي ستُعزز أمنك وخصوصيتك.

تنزيل: Archivarix (مجانًا ، الإصدار المدفوع مُتاح)

تنزيل مواقع الويب بالكامل بسهولة لاستخدامها دون اتصال بالإنترنت

الآن بعد أن عرفت كيفية تنزيل موقع ويب بأكمله ، يجب ألا تجد نفسك أبدًا بدون شيء لتقرأه ، حتى عندما لا يكون لديك اتصال بالإنترنت.

لكن تذكر: كلما زاد حجم موقع الويب ، زاد التنزيل. لذلك ، لا نوصي بتنزيل مواقع ضخمة لأنك ستحتاج إلى الكثير من التخزين الاحتياطي لتخزين جميع ملفات الوسائط التي تستخدمها مواقع الويب هذه. هل تريد فقط تنزيل صفحة ويب معينة لعرضها في وضع عدم الاتصال؟ يمكنك القيام بذلك بسهولة أيضًا. يُمكنك الإطلاع الآن على كيفية تنزيل أي شيء على الويب مجانًا: أفضل النصائح والأدوات.